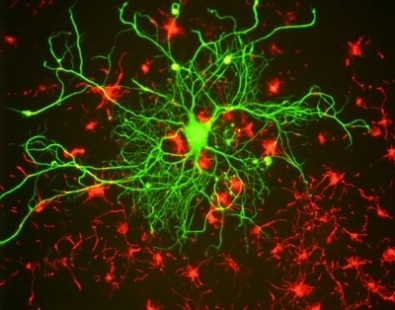

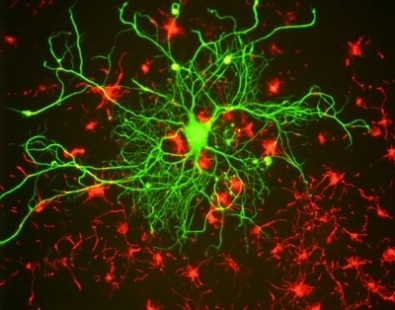

El ideal que orienta las investigaciones más avanzadas e innovadoras en el campo de la informática apunta a imitar la interconectividad, la densidad de información y la eficiencia energética del cerebro humano (imagen: red de neuronas/ GerryShaw/ Wikimedia Commons)

El ideal que orienta las investigaciones más avanzadas e innovadoras en el campo de la informática apunta a imitar la interconectividad, la densidad de información y la eficiencia energética del cerebro humano

El ideal que orienta las investigaciones más avanzadas e innovadoras en el campo de la informática apunta a imitar la interconectividad, la densidad de información y la eficiencia energética del cerebro humano

El ideal que orienta las investigaciones más avanzadas e innovadoras en el campo de la informática apunta a imitar la interconectividad, la densidad de información y la eficiencia energética del cerebro humano (imagen: red de neuronas/ GerryShaw/ Wikimedia Commons)

Por José Tadeu Arantes | Agência FAPESP – De todo lo que la ciencia contemporánea es capaz de observar en el Universo, nada supera o ni siquiera se compara en funcionalidad, plasticidad y eficiencia al propio cerebro humano. Éste es capaz de un procesamiento masivo de información en paralelo, con un consumo de energía por evento sináptico del orden del femtojoule, 10-15 J [a modo de comparación, una lámpara común de 100 vatios consume una cantidad de energía 100 mil billones de veces mayor por segundo ].

La mimetización de la interconectividad, la densidad de información y la eficiencia energética del cerebro humano, aunque más no fuera que en forma aproximada, es el ideal que orienta las investigaciones más avanzadas e innovadoras en el terreno de la medicina, la ingeniería y la informática.

Un dispositivo electroquímico orgánico recientemente elaborado en Estados Unidos constituye un aporte original en tal sentido. Este artefacto, denominado ENODe (del inglés Electrochemical Neuromorphic Organic Device), fabricado en sustrato flexible, opera en niveles de energía que pueden llegar al picojulio, 10-12 J, exhibe más de 500 estados estables de conductancia eléctrica y logra simular con precisión la función sináptica.

La investigación que dio origen al mismo fue objeto del artículo intitulado "A non-volatile organic electrochemical device las a low-voltage artificial synapse for neuromorphic computing", publicado en Nature Materiales.

Este estudio, llevado a cabo por el grupo encabezado por el químico italiano Alberto Salleo, en el Departamento de Ciencia de Materiales e Ingeniería de la Stanford University, contó con la participación del brasileño Gregorio Couto Faria, del Instituto de Física de São Carlos de la Universidad de São Paulo (IFSC-USP). Este último investigador contó con el apoyo de la FAPESP, mediante una Beca de Investigación en el Exterior.

“Pese a que es sumamente sencillo, el ENODe presenta una propiedad típica de las estructuras neurales, que es la memoria multinivelada. Cada unidad de nuestro cerebro manifiesta alrededor de 100 estados de potenciación que corresponden a distintos niveles de memoria. En nuestro experimento, al variar el voltaje, logramos alterar la conductividad del material activo, y así logramos acceder también a patrones diferenciados de memoria”, declaró el investigador a Agência FAPESP.

Este dispositivo está constituido esencialmente por un polímero conjugado, capaz de conducir no solamente electrones sino también iones. Esto le permite actuar como traductor –o para decirlo más precisamente, como transductor– de corriente eléctrica en corriente iónica. La gran virtud de esta propiedad reside en que le permite al material mimetizar los sistemas biológicos. “Dichos sistemas se comunican predominantemente mediante flujos iónicos. Cuando una neurona interactúa con otra, lo que hace es abrir canales al paso de los iones, y así polariza el ambiente circundante. Al reproducir esta función, nuestro polímero establece una interfaz entre sistemas artificiales y sistemas vivos”, informó Couto Faria.

Una aplicación inmediata consistiría en utilizar este dispositivo en sensores, para detectar la presencia de determinadas sustancias, o en prótesis destinadas al estímulo de tejidos vivos, tales como las células cardíacas, por ejemplo. Otra aplicación, mucho más ambiciosa, consiste en valerse de la propiedad de este material para proyectar y producir dispositivos electrónicos capaces de imitar estructuras biológicas, tales como las neuronas.

El desarrollo de la electrónica de polímeros conjugados les redituó el Premio Nobel de Química de 2000 a Alan Heeger (Estados Unidos), Alan MacDiarmid (Nueva Zelandia) y Hideki Shirakawa (Japón). En la familia de los polímeros conjugados, existe una clase específica de conductores eléctricos mixtos. Una de las ventajas de estos materiales con relación a sus análogos ineléctricos consiste en que tienen una morfología sumamente porosa, similar a la de la esponja. Cuando se los sumerge en un medio líquido con presencia de iones, absorben la solución en sus intersticios. Y su red de canales intersticiales se transforma en el sistema vial por donde pueden transitar los iones.

Durante el tránsito iónico, se producen reacciones de oxidación o reducción del polímero por acción de los iones. Se trata del fenómeno al cual en ciencia de materiales se le da el nombre de “dopaje”. La ganancia (en la oxidación) o la pérdida (en la reducción) de electrones tienen efectos sobre la conductividad eléctrica del material. Y la conductividad puede modularse a través de la variación de la tensión aplicada. “Esto es lo que le permite al dispositivo exhibir distintos niveles de memoria, configurando así una de las primeras condiciones para la elaboración de una estructura neuromórfica”, explicó el investigador.

La encrucijada de la computación

Las unidades neuromórficas integradas en redes neurales constituyen la opción más audaz con miras a superar el actual cuello de botella de la computación.

“En efecto, el desarrollo de la computación está llegando a una encrucijada. La llamada Ley de Moore, según la cual la cantidad de transistores integrados en las computadoras se duplica cada 18 meses, sigue vigente. Pero la velocidad de procesamiento, denominada ‘velocidad de clock’, no está creciendo proporcionalmente, y tiende a estabilizarse”, afirmó Couto Faria. Esto obedece a un conjunto de factores: al efecto Joule, por ejemplo, esto es, a la disipación de energía en forma de calor, que aumenta con la compactación y la miniaturización cada vez mayor de los componentes.

“Una de las propuestas tendientes a superar este impasse es la verticalización de las unidades de memoria. Es el mismo principio que se observa en la dinámica urbana. Cuando el área de expansión de las ciudades llega a un cierto límite, las urbes comienzan a verticalizarse. Lo propio tendería a ocurrir con los procesadores. Otra salida, más innovadora, es el reemplazo de la computación de tipo Von Neumann [en referencia al matemático húngaro de origen judío John von Neumann (1903-1957)], adoptada desde los albores de la revolución informática, por una computación neuromórfica, que apunta a mimetizar el funcionamiento del cerebro”, ponderó el investigador.

En la computación tradicional, el bit, la menor unidad de información que puede almacenarse o transmitirse, se resume a la alternativa “uno o cero”. E informa si en ese punto el circuito está cerrado para permitir el paso de la corriente eléctrica, o si está abierto, obstruyendo de tal modo la señal. En síntesis, es “sí o no”, y no existe un término medio. En la computación neuromórfica, cada unidad básica podría exhibir varios estados posibles: “sí”, “no” y distintos tipos de “quizá”.

Asimismo, las redes neurales presentarían patrones de plasticidad y capacidad de aprendizaje cada vez más similares a los de las estructuras biológicas. Esto significa que muchas unidades distintas podrían sincronizarse, de manera tal que el patrón eléctrico de una sería aprendido y asumido por otra.

“Junto a la memoria multinivelada, la capacidad de aprendizaje constituye una característica sumamente importante del ENODe”, subrayó Couto Faria. “Para chequear esta capacidad, le aplicamos al dispositivo el test del ‘perro de Pávlov’.”

Este test, basado en los experimentos realizados por el fisiólogo ruso Iván Petróvich Pávlov (1849-1936), asocia la oferta de comida al sonido de una campañilla. Después de vivenciar tal situación, el perro, que saliva instintivamente al ver u olfatear la comida, pasa a salivar a cada vez que escucha la campañilla, aun en ausencia de comida.

“Lo que hicimos fue reproducir ese tipo de condicionamiento animal utilizando dos sistemas neuromórficos, uno referente a la vista (que mimetiza la visión de la comida), y otro relativo al oído (mimetizando la audición de la campanilla). La variación de conductividad en función del potencial eléctrico, que ocurría en el sistema de la vista, fue ‘aprendida’ por el sistema del oído cuando se integraron ambos sistemas”, describió el investigador.

Parece complicado. Pero en el fondo, todo se resume al dopaje de la estructura del polímero debido al flujo iónico.

Las computadoras actuales, de tipo Von Neumann, ya son capaces de aprender mediante ensayo y error. A esto en lenguaje técnico se le denomina “aprendizaje de máquinas”, y se registra incluso en los teléfonos móviles inteligentes de última generación. Un jalón en esta trayectoria evolutiva se produjo en 1997, cuando el campeón mundial de ajedrez Garri Kaspárov, a quien muchos consideran el mayor ajedrecista de todos los tiempos, perdió una partida contra la computadora Deep Blue, de IBM.

Otro hito se concretó en 2011, cuando una máquina aún más avanzada de IBM, la supercomputadora Watson, derrotó a los dos campeones del programa Jeopardy!, un evento popular de preguntas y respuestas de la televisión estadounidense (lea en: http://agencia.fapesp.br/23290/). Con 15 billones de bytes (conjuntos de ocho bits) de memoria, el equivalente a 5.000 computadoras operando masivamente en paralelo, Watson es capaz de leer 500 millones de páginas en 3 segundos. En el torneo, se valió del aprendizaje de máquinas para entender las preguntas capciosas de los presentadores, encontrar las presumibles respuestas, clasificarlas en un ranking estadístico y elegir la alternativa más probable en segundos o fracciones de segundo.

Pero a lo que se apunta ahora es a otro tipo de aprendizaje, ya no basado en la acumulación de bytes en máquinas gigantescas sino en unidades de procesamiento multiniveladas, integradas en redes capaces de mimetizar la plasticidad del cerebro humano.

El dispositivo puesto a prueba en el experimento de Stanford posee un tamaño macroscópico, del orden de milímetros. Pero es pasible de miniaturización a escala nanométrica mediante fotolitografía. “Nuestro gran objetivo consiste en conectar varios dispositivos neuromórficos y mimetizar redes neurales capaces de ejecutar funciones cada vez más complejas”, resumió Couto Faria. En el horizonte se encuentra la computadora neuromórfica.

Republicar

The Agency FAPESP licenses news via Creative Commons (CC-BY-NC-ND) so that they can be republished free of charge and in a simple way by other digital or printed vehicles. Agência FAPESP must be credited as the source of the content being republished and the name of the reporter (if any) must be attributed. Using the HMTL button below allows compliance with these rules, detailed in Digital Republishing Policy FAPESP.