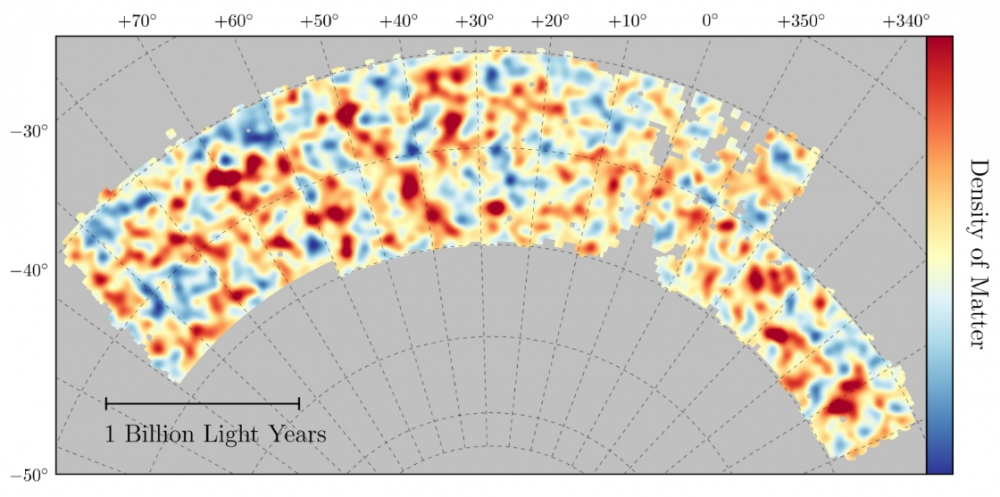

O mapa já elaborado pelo Dark Energy Survey cobre cerca de 1/30 do céu. E mostra a distribuição da matéria escura nessa região. As áreas mais vermelhas têm maior concentração de matéria escura do que a média, enquanto as áreas azuis têm menor (imagem: Dark Energy Survey)

O levantamento vai rastrear um oitavo do céu e fotografar mais de 300 milhões de galáxias, 100 mil aglomerados de galáxias e 2 mil estrelas supernovas, entre outros objetos

O levantamento vai rastrear um oitavo do céu e fotografar mais de 300 milhões de galáxias, 100 mil aglomerados de galáxias e 2 mil estrelas supernovas, entre outros objetos

O mapa já elaborado pelo Dark Energy Survey cobre cerca de 1/30 do céu. E mostra a distribuição da matéria escura nessa região. As áreas mais vermelhas têm maior concentração de matéria escura do que a média, enquanto as áreas azuis têm menor (imagem: Dark Energy Survey)

José Tadeu Arantes | Agência FAPESP – A matéria conhecida (denominada “bariônica”) corresponde a apenas 5% do conteúdo do Universo. Outros 25% são constituídos pela desconhecida matéria escura. E 70%, pela ainda mais enigmática energia escura. Estas porcentagens (aqui expressas em valores arredondados), que haviam sido estabelecidas por estudos anteriores, foram confirmadas agora, com notável convergência numérica, pelo Dark Energy Survey (DES).

Conduzido por uma colaboração internacional, o DES é um mapeamento do Universo em grande escala, que deverá rastrear uma área equivalente a um oitavo do céu (5 mil graus quadrados) e levantar dados sobre mais de 300 milhões de galáxias, 100 mil aglomerados de galáxias e 2 mil estrelas supernovas, além de milhões de estrelas da Via Láctea e objetos do Sistema Solar.

Com a atividade iniciada em 2013 e prevista para prosseguir até 2018, a colaboração acaba de divulgar os dados sistematizados de seu primeiro ano de trabalho. Esses dados possibilitaram a elaboração de um mapa, com 26 milhões de galáxias, que cobre cerca de 1/30 do céu e apresenta a distribuição heterogênea da matéria escura em uma faixa de bilhões de anos-luz de extensão.

Outro destaque no material divulgado pela colaboração é que os dados sistematizados do primeiro ano são consistentes com a interpretação mais simples acerca da natureza da energia escura. Segundo tal interpretação, esse misterioso ingrediente, que faz com que a expansão do Universo esteja sendo acelerada em vez de retardada, seria a energia do vácuo. E corresponderia à constante cosmológica (Λ), inicialmente proposta e depois abandonada por Einstein. De acordo com o modelo, a quantidade total dessa energia aumenta, em decorrência da própria expansão, mas sua densidade se mantém constante, no espaço e no tempo.

A questão da natureza da energia escura, porém, permanece aberta. E não pode ser descartada a possibilidade de que dados já colhidos, mas ainda em fase de sistematização, ou que venham a ser obtidos até o final do levantamento, desfavoreçam essa interpretação em benefício de outras, mais sofisticadas.

Liderado pelo Fermilab (Fermi National Accelerator Laboratory), dos Estados Unidos, o DES reúne mais de 400 pesquisadores de vários países – entre eles, vários cientistas brasileiros. A participação brasileira, realizada por meio de um consórcio denominado DES-Brazil, é coordenada pelo Laboratório Interinstitucional de e-Astronomia (LIneA), com sede no Rio de Janeiro. O LIneA desenvolveu também um portal específico para o DES e coordena a participação brasileira no Large Synoptic Survey Telescope (LSST), que deverá suceder o DES e já está em construção no Chile.

No Estado de São Paulo, as pesquisas têm à frente Rogério Rosenfeld, ex-diretor do Instituto de Física Teórica da Universidade Estadual Paulista (Unesp) e vice-coordenador do INCT do e-Universo, Marcos Lima , professor do Instituto de Física da Universidade de São Paulo (USP) e Flavia Sobreira, professora do Instituto de Física Gleb Wataghin da Universidade Estadual de Campinas (Unicamp), todos eles apoiados pela FAPESP.

“A região mapeada pelo DES em seu primeiro ano de atividade foi a maior área contígua do céu já observada por um único levantamento. Para tanto, utilizou-se uma câmera digital de altíssima resolução, a Decam (Dark Energy Camera), de 570 megapixels, instalada no plano focal do telescópio de 4 metros de diâmetro do Observatório Internacional de Cerro Tololo, no Chile”, informou Rosenfeld à Agência FAPESP.

“Os milhões de galáxias foram fotografos usando cinco filtros diferentes, de modo a propiciar a medida de seu brilho em cinco janelas do espectro visível, cada qual definida por um intervalo de comprimentos de onda. Desse modo foi possível estimar seus redshifts [desvios para o vermelho da luz emitida]”, acrescentou o pesquisador.

Cabe aqui uma explicação. Conforme descobriu o astrônomo norte-americano Edwin Hubble (1889 —1953), cujo nome foi atribuído ao telescópio espacial, ainda operante, o Universo encontra-se em expansão. E a velocidade com que as galáxias longínquas se afastam do observador terrestre é tanto maior quanto mais distantes elas se encontrem. O afastamento faz com que a luz emitida pelas galáxias se desloque para o vermelho – isto é, para a banda de maior comprimento de onda. E que o desvio para o vermelho cresça com a distância. Tal fenômeno deve-se ao chamado Efeito Doppler – o mesmo que torna o som da sirene de um veículo mais agudo quando ele se aproxima e mais grave quando se afasta.

Por meio do redshift, e valendo-se da Lei de Hubble, os astrônomos calculam as distâncias dos objetos observados. Para isso, recorrem principalmente à espectroscopia – isto é, à decomposição da luz no seu espectro de frequências. A espectroscopia permite determinar com muita exatidão o desvio das bandas do espectro para o vermelho. Porém torna-se praticamente inviável em um levantamento como o do DES, que envolve a observação de dezenas a centenas de milhões de galáxias. Embora não tenha a mesma acurácia da espectroscopia, a fotometria, isto é, a mensuração da intensidade da luz em diferentes filtros, constitui um método alternativo no caso. O que se perde em qualidade é largamente compensado pelo que se ganha em quantidade.

“Além disso, a fotometria informa não apenas o redshift, e, portanto, a distância, da galáxia observada. Informa também o seu formato. E essa determinação do formato é muito importante, porque um dos efeitos da matéria no Universo é a criação de lentes gravitacionais, que distorcem ligeiramente a luz recebida de fontes distantes. Desse modo, por meio da fotometria, o DES está fazendo o levantamento tanto da distribuição das galáxias quanto da ligeira distorção de suas formas, produzidas pelo chamado ‘lenteamento gravitacional fraco’. Por meio desse efeito, é possível mapear toda a matéria existente no espaço compreendido entre as fontes emissoras de luz e nós – tanto a matéria luminosa quanto a muito mais abundante matéria escura”, enfatizou Rosenfeld. A combinação das medidas da distribuição de galáxias com as de lenteamento gravitacional fraco resultaram em estimativas precisas de propriedades do Universo.

Diferentemente do “lenteamento gravitacional forte”, capaz de gerar múltiplas imagens do mesmo objeto, e até mesmo arcos ou anéis, o “lenteamento gravitacional fraco” produz distorções extremamente sutis, da ordem de 1%, nas posições e nas formas das galáxias observadas. E são essas distorções que estão possibilitando construir um mapa muito preciso da distribuição da matéria escura.

A pesquisadora Flavia Sobreira resumiu o histórico do levantamento: “A esfera celeste, isto é, todo o céu observável a partir da Terra, possui uma área de cerca de 40 mil graus quadrados. O objetivo do DES é mapear um oitavo dessa área, ou seja, 5 mil graus quadrados. No primeiro ano de atividade, foi mapeado 1/30 da área total. Para isso, construímos a câmera Decam, que possui uma definição fora do comum, e, utilizando cinco filtros diferentes, compusemos um catálogo de galáxias. Registramos as formas das galáxias do catálogo e medimos as distorções nelas produzidas pelo campo gravitacional existente no espaço atravessado pela luz emitida por esses objetos. Como o campo gravitacional é causado por matéria, esse procedimento permitiu fazer um mapa da distribuição de matéria. E, subtraindo a matéria luminosa, chegar à distribuição de matéria escura na faixa observada”, disse.

Evolução cósmica

Para entender a contribuição gravitacional da matéria escura à estruturação do Universo, é interessante recapitular, ainda que de forma muito resumida, o modelo mais aceito sobre a evolução cósmica.

Segundo tal modelo, o Universo teve um “início” extremamente quente e denso. À medida que se expandiu, sua temperatura e densidade diminuíram. A matéria escura, por interagir muito fracamente, logo deixou de trocar energia com outros componentes (ou “desacoplou”, como os físicos preferem dizer), enquanto o restante do conteúdo continuou acoplado em um plasma quente de bárions (que constituem a matéria conhecida) e fótons (que constituem a radiação eletromagnética). O acoplamento prosseguiu até que a expansão tornou as distâncias entre os componentes do plasma suficientemente grandes para que os fótons deixassem de interagir com a matéria bariônica e passassem a viajar livremente pelo espaço.

Esse segundo desacoplamento, denominado “recombinação”, teria ocorrido cerca de 400 mil anos depois do Big Bang. Livre da pressão dos fótons, a matéria bariônica começou, então, a se aglutinar em torno das regiões com maior potencial gravitacional, isto é, aquelas que possuíam maior densidade de matéria escura. Desse modo, a matéria escura atuou como “atratora gravitacional” para que as primeiras estruturas começassem a ser produzidas.

Os fótons desacoplados compõem, atualmente, a radiação cósmica de fundo, observada na faixa de micro-ondas. Enquanto que a matéria bariônica formou nuvens de gás, estrelas, planetas e galáxias. A observação da radiação cósmica de fundo, realizada pelos satélites COBE (Nasa, 1989 – 1993), WMAP (Nasa, 2001 – 2010) e Planck (ESA, 2009 – 2013), forneceu a “fotografia” de um universo muito jovem, com apenas 400 mil anos de idade. Ao passo que a observação da distribuição de galáxias, realizada agora pelo DES, fornece a “fotografia” de um universo bilhões de anos mais velho. O notável é que essas duas “fotografias” são totalmente compatíveis. “Combinados com outras observações, os dados fornecidos pelos dois mapas, que registram objetos diferentes, permitem chegar aos mesmos números”, sublinhou Sobreira.

A natureza da matéria escura é um ponto de interrogação. “Existe quase que um consenso na comunidade científica de que se trata de um tipo diferente de partícula elementar, que não possui carga elétrica, e, por isso, não interage com a radiação eletromagnética. Por não interagir com a luz, seria mais correto chamá-la de ‘transparente’, em vez de ‘escura’. O DES trabalha com a hipótese de que a matéria escura seja constituída por ‘partículas frias’ (cold dark matter). A palavra ‘frias’, no caso, significa apenas que essas partículas não teriam velocidades relativísticas [próximas à da luz]. Mas existem outras hipóteses, como a das ‘partículas mornas’ (warm dark matter). Eu tenho uma aluna, Jéssica Martins, trabalhando com essa segunda hipótese”, afirmou Rosenfeld.

Vale mencionar aqui outro orientando de Rosenfeld que se destacou no levantamento do DES. Trata-se de Nickolas Kokron, aluno de Iniciação Científica, com bolsa da FAPESP. “Há duas maneiras de estudar a distribuição de galáxias. Uma é no espaço real. Outra, no espaço de Fourier. Nickolas está trabalhando nas medidas da distribuição no espaço de Fourier, que fornecem o chamado ‘espectro de potência angular’. Ele acabou de se graduar e já está praticamente liderando os trabalhos nessa área”, comentou o orientador.

Os dados sistematizados do primeiro ano do levantamento, agora divulgados pelo DES, permitiram determinar com bastante exatidão o percentual de matéria escura, mas não sua natureza. Nem é provável que o levantamento de cinco anos venha a contribuir para isso. “O motivo é que a natureza da matéria escura, que se manifesta na intensidade de suas autointerações e na massa de suas partículas, teria efeito em escalas menores. Chegar a algum resultado conclusivo com um estudo em grande escala é extremamente complicado”, ponderou Marcos Lima. “O que o levantamento já mostrou, isto sim, foi que os dados são consistentes com o modelo mais simples de energia escura. E esta é uma questão que talvez venha a ser inteiramente resolvida pelo DES”, continuou.

Embora os resultados sejam ainda bastante parciais, os dados do primeiro ano já possibilitaram determinar com muita precisão a quantidade de energia escura. E isso foi feito a partir da distribuição, no mapa, das galáxias mais próximas, e do efeito de lenteamento que elas causam em galáxias distantes. Porque, quanto maior o percentual de energia escura, mais rápida a expansão, e, consequentemente, menor a quantidade de estruturas formadas – uma vez que as estruturas se formam por atração gravitacional, e a rápida expansão induzida pela energia escura se contrapõe à atração gravitacional que causa tal formação. “Vinculando a quantidade de estruturas, obtida pelo DES, com medidas anteriores, realizadas por outros experimentos, foi possível confirmar com muita precisão o percentual de 70% para o conteúdo de energia escura”, afirmou o pesquisador.

“A expectativa agora é vincular também uma outra propriedade da energia escura, que é sua equação de estado, definida como a razão entre sua pressão e sua densidade. Com medidas precisas tanto da densidade quanto da equação de estado da energia escura, será possível inferir, também, a natureza desse componente. Porque diferentes modelos acerca da natureza da energia escura levam a diferentes predições numéricas dos seus efeitos na expansão e na formação de estruturas”, explicou Lima.

A próxima grande síntese a ser divulgada pela colaboração deverá unificar os dados coletados nos três primeiros anos. E já estão sendo processados os dados do quarto ano. “Porém, mesmo em relação aos dados do primeiro ano, ainda não foram feitas todas as análises. Só foram analisados os dados relativos à distribuição de galáxias e às lentes gravitacionais. Há dados sobre supernovas e sobre aglomerados de galáxias que estão em fase de análise”, ressalvou Lima.

Isso acena com a possibilidade de que novidades importantes venham a ser anunciadas em breve. As observações de supernovas deverão fornecer informações ainda mais precisas sobre energia escura, pois permitem aferir, de maneira quase direta, o valor da taxa de expansão do Universo. Deve-se lembrar que foi utilizando as supernovas como marcadores que o Supernova Cosmology Project e o High-z Supernova Search Team descobriram, no final dos anos 1990, que a expansão do Universo estava sendo acelerada. Os norte-americanos Saul Perlmutter e Adam Riess e o australiano Brian Schmidt receberam o Prêmio Nobel de Física de 2011 pela descoberta.

Onde isso tudo pode levar? “A energia escura não é a única explicação possível para a aceleração da expansão do universo. Uma outra possibilidade é que o próprio entendimento da gravitação tenha que ser alterado. Assim como Einstein generalizou a teoria gravitacional de Newton, discute-se agora se não seria necessário generalizar a teoria de Einstein, e ir além da relatividade geral, rumo às chamadas ‘teorias de gravidade modificadas’. Essas duas explicações, energia escura e gravidade modificada, fazem predições muito diferentes sobre como o universo se expande e, principalmente, sobre como as perturbações crescem nesse universo em expansão. Os dados já divulgados são totalmente consistentes com a interpretação da energia escura como constante cosmológica, que é o modelo mais simples de todos, com equação de estado exatamente igual a (-1). Mas outras possibilidades não estão excluídas”, finalizou Lima.

Republicar

A Agência FAPESP licencia notícias via Creative Commons (CC-BY-NC-ND) para que possam ser republicadas gratuitamente e de forma simples por outros veículos digitais ou impressos. A Agência FAPESP deve ser creditada como a fonte do conteúdo que está sendo republicado e o nome do repórter (quando houver) deve ser atribuído. O uso do botão HMTL abaixo permite o atendimento a essas normas, detalhadas na Política de Republicação Digital FAPESP.