En el marco de un proyecto del Programa de Investigación Innovadora en Pequeñas Empresas de la FAPESP, se apunta a adaptar esta tecnología aún experimental y de alto costo para que pueda salir al mercado

En el marco de un proyecto del Programa de Investigación Innovadora en Pequeñas Empresas de la FAPESP, se apunta a adaptar esta tecnología aún experimental y de alto costo para salir al mercado

En el marco de un proyecto del Programa de Investigación Innovadora en Pequeñas Empresas de la FAPESP, se apunta a adaptar esta tecnología aún experimental y de alto costo para salir al mercado

En el marco de un proyecto del Programa de Investigación Innovadora en Pequeñas Empresas de la FAPESP, se apunta a adaptar esta tecnología aún experimental y de alto costo para que pueda salir al mercado

Por Karina Toledo | Agência FAPESP – Científicos de la Facultad de Ingeniería Eléctrica y Computación de la Universidad de Campinas (FEEC/ Unicamp), en São Paulo, Brasil, desarrollaron una silla de ruedas que puede controlarse mediante pequeños movimientos del rostro, la cabeza o el iris.

El artefacto se encuentra aún en etapa experimental y tiene un alto costo. Así y todo, un proyecto aprobado recientemente en el marco del Programa de Investigación Innovadora en Pequeñas Empresas (PIPE), de la FAPESP, tiene como objetivo adaptar esta tecnología, a los efectos de que se vuelva más accesible y pueda salir al mercado brasileño dentro de dos años.

“Nuestro objetivo es que el producto final cueste a lo sumo el doble que una silla motorizada común, de esas que se controlan con un joystick y actualmente cuestan alrededor de siete mil reales”, dijo Eleri Cardozo, docente de la FEEC/ Unicamp, quien presentó resultados de la investigación durante el 3rd BRAINN Congress, realizado en Campinas entre los días 11 y 13 de abril de 2016.

Según Cardozo, esta tecnología podrá beneficiar a personas tetraplégicas, víctimas de accidentes cerebrovasculares (ACVs), portadores de esclerosis lateral amiotrófica u otras condiciones de salud que impiden el movimiento preciso de las manos.

Este trabajo, que empezó en 2011, contó inicialmente con el apoyo de la Financiadora de Estudios y Proyectos (Finep) y se desarrolla actualmente en el ámbito del Instituto de Investigaciones sobre Neurociencias y Neurotecnología (BRAINN), un Centro de Investigación, Innovación y Difusión (CEPID) que cuenta con el apoyo de la FAPESP.

“Nuestro grupo estudiaba técnicas de interfaz cerebro-computadora [BCI, por sus siglas en inglés, métodos de adquisición y procesamiento de señales que permiten la comunicación entre el cerebro y un dispositivo externo] y creímos que sería interesante evaluar la tecnología en una situación real”, comentó Cardozo.

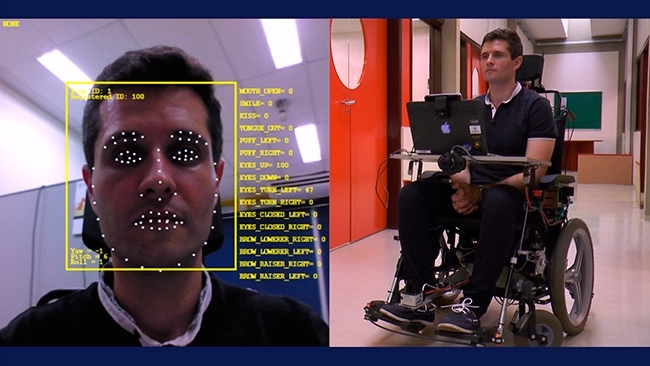

El grupo adquirió entonces una silla motorizada convencional, retiró el joystick y la equipó con diversos dispositivos normalmente encontrados en robots, tales como sensores capaces de medir la distancia con respecto a las paredes y otros objetos, o detectar diferencias de profundidad en el piso.

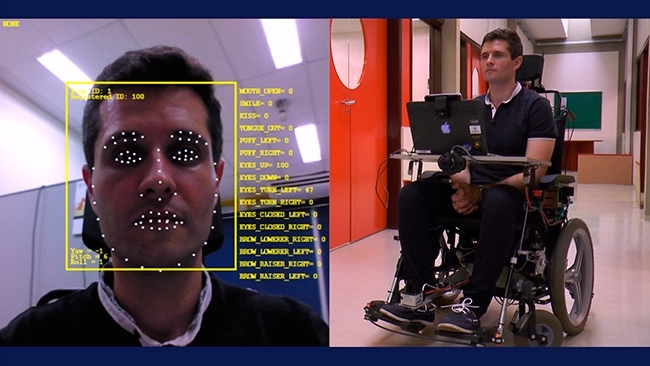

El prototipo también fue equipado con una notebook que envía los comandos directamente a la silla y con una cámara 3D con la tecnología RealSense, de Intel, que permite interactuar con el ordenador mediante expresiones faciales o movimientos corporales.

“La cámara identifica más de 70 puntos del rostro –situados alrededor de la boca, la nariz y los ojos– y, con base en el movimiento de esos puntos, es posible extraer comandos sencillos, tales como avanzar, retroceder, girar a la izquierda o a la derecha y, lo que es más importante, detenerse”, explicó Cardozo.

También es posible interactuar con la computadora mediante comandos de voz, pero se considera que esa tecnología es menos confiable que las expresiones faciales, debido a las diferencias de timbre y a la posible interferencia del ruido del ambiente.

“Esas limitaciones pueden subsanarse con la definición de una cantidad reducida de comandos y con una función de entrenamiento incorporada al software que optimiza la identificación de los comandos para un usuario específico”, dijo Cardozo.

Pensando en pacientes con cuadros aún más graves –que impiden incluso el movimiento facial–, el grupo también trabaja en una tecnología de BCI que permite extraer señales directamente del cerebro, mediante electrodos externos, y transformarlos en comandos. Pero este aparato aún no ha sido instalado en la silla robotizada.

“Hicimos demostraciones en las cuales una persona permanece sentada en la silla y otra, sentada cerca de una mesa, utiliza el casco con los electrodos y la controla. Antes de instalar el aparato de BCI en la silla, necesitamos resolver algunas limitaciones, tal como la alimentación de energía. Es una tecnología muy cara aún, pero está saliendo una nueva generación de bajo costo, en la cual el casco puede imprimirse en 3D”, dijo Cardozo.

La silla también quedó equipada como una antena wifi que permite que un cuidador dirija el aparato en forma remota, vía internet. “Esas interfaces requieren que el usuario mantenga un nivel de concentración que puede ser cansador. Por eso, de ser necesario, en cualquier momento otra persona puede asumir su control”, comentó Cardozo.

Una startup

Entre las metodologías que el equipo de la Unicamp ha probado, la interfaz basada en la captura y procesamiento de expresiones faciales ha demostrado que es la más prometedora a corto plazo y, por ende, en ella se enfocará el proyecto desarrollado en el ámbito del programa PIPE, bajo la coordinación del investigador Paulo Gurgel Pinheiro. Para ello, el grupo creó la startup HOO.BOX Robotics.

“La empresa es un spin-off de mi posdoctorado, cuyo objetivo consistió en desarrollar interfaces destinadas a manejar una silla de ruedas con el mínimo esfuerzo posible del usuario. Inicialmente probamos sensores capaces de captar contracciones de los músculos de la cara, y luego evolucionamos hacia tecnologías de imágenes capaces de captar expresiones faciales sin necesidad de sensores”, comentó Gurgel Pinheiro.

En lugar de crear una silla robotizada, tal como es el caso del prototipo de la Unicamp, el grupo pretende –para achicar los costos– desarrollar un software y una minigarra mecánica que podrían implantarse en cualquier silla motorizada con joystick existente en el mercado.

“Nuestra idea consiste en que el usuario pueda bajar el software que realizará el procesamiento de las expresiones faciales en su notebook. La computadora estará conectada a esa minigarra a través de un puerto USB. Cuando hace las expresiones claves, tales como un beso o una media sonrisa, o fruncir la nariz, inflar los cachetes o levantar las cejas, el software envía el comando a la garra y ésta mueve el joystick. De esta forma, no alteramos la estructura de la silla y ésta no pierde la garantía”, explicó Pinheiro.

El investigador estima que un prototipo del sistema, bautizado Wheelie, estará listo a comienzos de 2017. Habrá que sortear en el lapso que dista hasta entonces dos desafíos: mejorar la clasificación de las expresiones faciales, de manera tal de evitar que la interpretación de las señales se vea perjudicada debido a diferencias en la iluminación del ambiente y asegurarse de que solamente las expresiones faciales del usuario de la silla sean capturadas cuando haya otras personas cerca.

“En el futuro, esta tecnología también podrá ayudar en la recuperación de personas que padecieron ACVs u otros tipos de lesiones cerebrales, pues el paciente podrá observar el avance en la realización de movimientos y se motivará más para seguir el tratamiento”, dijo Pinheiro.

Republicar

The Agency FAPESP licenses news via Creative Commons (CC-BY-NC-ND) so that they can be republished free of charge and in a simple way by other digital or printed vehicles. Agência FAPESP must be credited as the source of the content being republished and the name of the reporter (if any) must be attributed. Using the HMTL button below allows compliance with these rules, detailed in Digital Republishing Policy FAPESP.